Wie lässt sich eine leistungsstarke KI bei geringem Stromverbrauch an der Edge einsetzen?

06.12.2023 - KI-Modelle auf FPGAs für Edge-Anwendungen

Intelligente Sensoren werden zunehmend in Edge-Anwendungen eingesetzt, wo sie eine Flut von Daten erzeugen. Diese Datenflut hat einen lokalen Kontext, ist äußerst zeitkritisch und erfordert in vielen Fällen eine Analyse mit geringer Latenzzeit. Der Zeit-, Energie- und Kostenaufwand für einen Hin- und Rückweg zu einem Rechenzentrum ist hier keine Option. Zunehmend wird daher künstliche Intelligenz (KI) eingesetzt, um Erkenntnisse aus dem Datenstrom zu gewinnen.

Die Welt produziert Daten in einem exponentiell steigenden Tempo. Kostengünstige intelligente Sensoren werden in Edge-Anwendungen eingesetzt, wo sie eine Flut von Daten erzeugen, die Aufschluss über eine Vielzahl messbarer Parameter geben. Ob es sich nun um die Lidar-Sensoren der autonomen Robotik, die Bildsensoren der industriellen Inspektion oder die zunehmende Vielfalt an intelligenten IoT-Geräten für Verbraucher handelt, diese Datenflut hat einen lokalen Kontext, ist hochgradig zeitempfindlich und erfordert in vielen Fällen eine Analyse mit geringer Latenzzeit. Der Zeit-, Energie- und Kostenaufwand für eine Hin- und Rückfahrt zu einem Rechenzentrum ist zunehmend keine Option mehr, und die Analyse muss schnell erfolgen, direkt dort, wo die Daten erzeugt werden. Die höhere Auflösung, Vielfalt und Menge der Sensoren bedeutet, dass die Analyse mit herkömmlichen Mitteln problematisch wird und zunehmend künstliche Intelligenz (KI) eingesetzt wird, um Erkenntnisse aus dem Datenstrom zu gewinnen.

Die Verlagerung von KI an den Edge-Bereich und die Replizierung ihrer Fähigkeiten auf eine Vielzahl von Sensoren und Umgebungen ist eine Herausforderung. Edge-Anwendungen zeichnen sich durch ihren geringen Stromverbrauch, ihre geringe Größe und ihre Kostensensibilität aus. Die rasante Entwicklung der KI und die Kosten für kundenspezifische Chips machen ASIC-Ansätze für alle Anwendungen mit Ausnahme der größten Stückzahlen unerschwinglich. Herkömmlichen CPU-, GPU- und FPGA-Lösungen fehlt entweder das geforderte Leistungsprofil oder die deterministische Fähigkeit, in Echtzeit zu reagieren.

Genug Rechenleistung für Echtzeit-Analysen an der Edge

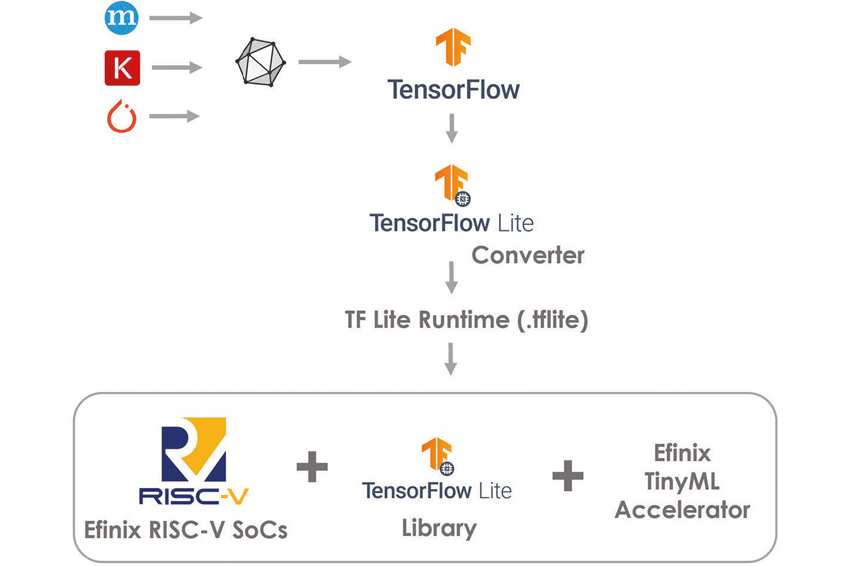

In den letzten Jahren hat die Open-Source-Gemeinschaft große Fortschritte bei der Entwicklung der KI-Modelle gemacht, um sie besser für Mikrocontroller-Architekturen im Edge-Bereich anzupassen. Tools wie Tensorflow Lite können die Komplexität und den Rechenbedarf von KI-Modellen reduzieren, um sie für Mikrocontroller-Implementierungen tauglich zu machen. Diese passen sich den Leistungs- und Größenbeschränkungen von Edge-Anwendungen an, bieten aber in vielen Fällen nicht die nötige Leistung, um in Echtzeit zu reagieren. Efinix hat sich dieser Herausforderung mit seiner Tiny-ML-Plattform gestellt, die die erforderliche Rechenleistung für Echtzeit-Analysen liefert und gleichzeitig die Anforderungen an den Stromverbrauch und den Platzbedarf für Edge-Anwendungen einhält.

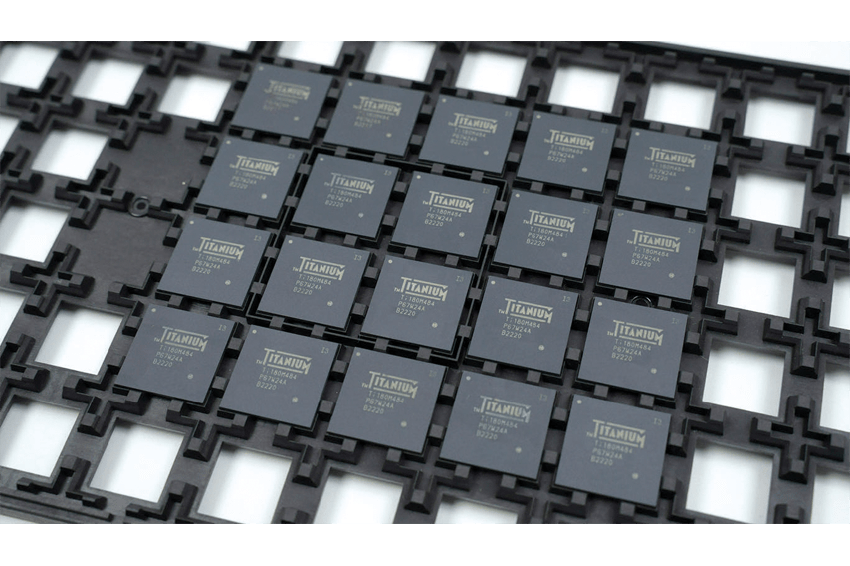

Efinix FPGAs verfügen über eine revolutionäre Fabric-Architektur, die hohe Rechenleistung in einem kleinen, stromsparenden Baustein bietet. Das macht sie zu einer natürlichen Anpassung für konventionelle Edge-Anwendungen. Die Bausteine der Titanium-Familie verfügen über Hard- und Soft-Versionen des branchenführenden Sapphire Risc-V-Prozessors, der eine Linux-kompatible Quad-Core-Rechenleistung bietet. Die Kombination aus einem hochleistungsfähigen Rechenkern und einer stromsparenden, hochleistungsfähigen FPGA-Fabric eröffnet ein enormes Potenzial für KI-Implementierungen im Edge-Bereich.

Risc-V-Prozessoren haben eine offene Befehlssatzarchitektur, bei der nicht alle Befehle eine vordefinierte Funktionalität haben. Einige Befehle und Befehlserweiterungen sind für den Entwickler frei definierbar. Bei benutzerdefinierten Chip-Anwendungen kann so die Funktionalität des Prozessors zur Entwurfszeit an die Anforderungen der Anwendung angepasst werden. In einem FPGA-Design kommt diese Fähigkeit erst richtig zur Geltung, da benutzerdefinierte Befehle definiert und in Hardware direkt neben dem Prozessor implementiert werden können. Dies ist das Grundprinzip der Efinix Tiny-ML-Plattform.

KI-Modell hundertfach beschleunigen durch Risc-V-Prozessor

KI-Modelle, die mit dem Tool Tensorflow Lite für Edge-Anwendungen angepasst wurden, bestehen aus einem vordefinierten Satz von Bausteinen, die typischerweise auf einer Mikrocontroller-Architektur mit einer Open-Source-Bibliothek implementiert werden. Diese Modelle können ohne weitere Optimierung auf dem Efinix Sapphire-Kern ausgeführt werden. Durch die Implementierung dieser Grundelemente als benutzerdefinierte Befehle kann der Risc-V-Kern jedoch so angepasst werden, dass Tensorflow Lite-Modelle mit nahezu Hardware-Geschwindigkeit ausgeführt werden können, während die Gesamtkontrolle in der Software verbleibt. Der Datenfluss wird in der Software gesteuert, während die grundlegenden Operationen, aus denen das Modell besteht und die zur Laufzeit wiederholt aufgerufen werden, als benutzerdefinierte Anweisungen implementiert sind, die innerhalb des Software-Flows aufgerufen werden. Operationen, die in benutzerdefinierten Anweisungen instanziert sind, können viele hundert Mal schneller ausgeführt werden als die entsprechenden Operationen, die nur in der Software ausgeführt werden. Das Ergebnis ist eine drastische Beschleunigung des gesamten KI-Modells, wenn es auf einem Risc-V-Prozessor läuft, der für die Ausführung der Tensorflow Lite-Grundelemente in Hardware optimiert ist.

Efinix hat ein Tiny-ML-Plattform-Konfigurationswerkzeug entwickelt, das ein Tensorflow-Lite-Modell analysieren und eine Reihe von vordefinierten benutzerdefinierten Anweisungen empfehlen kann, die zur Beschleunigung des Modells verwendet werden könnten. Eine grafische Benutzeroberfläche wird dem Designer präsentiert, so dass die Auswahl aus der Liste der vorgeschlagenen Beschleuniger so einfach wie ein Mausklick ist. Die benutzerdefinierten Anweisungen werden im Projekt des Designers instanziiert und können anstelle der mit der Tensorflow-Laufzeitbibliothek gelieferten Routinen aufgerufen werden. Auf diese Weise kann der Designer ein Tiny-ML-Modell, das auf einem Efinix-FPGA läuft, mit nur wenigen Mausklicks analysieren und beschleunigen. Das Ergebnis ist ein leistungsfähiges KI-Modell, das in einem strom- und platzsparenden Edge-Ready-Design läuft.

Weitere Vorteile des Efinix-FPGA-Ansatzes für KI im Edge-Bereich sind, dass Rohdaten von externen Sensoren auf dem FPGA direkt neben dem Risc-V-Prozessor vorverarbeitet werden können. Dies optimiert den kleinen Formfaktor dieses Ansatzes und ermöglicht eine hochspezifische Sensorvorverarbeitung, bevor die Datenanalyse durchgeführt wird. Efinix hat ein Framework für diese Art der Vorverarbeitung entwickelt und stellt es als Open-Source-Lösung als Ressource für Entwickler zur Verfügung.

Beispiele auf Github frei verfügbar

Im Geiste der Open-Source-Community hat Efinix viele der benutzerdefinierten Anweisungen und Pre-Processing-Beschleunigungs-Frameworks auf dem Efinix GitHub zur Verfügung gestellt. Beispiel-Designs, KI-Modelle und Tutorials führen den Entwickler durch den Prozess der Anpassung und Beschleunigung beliebter KI-Modelle. In vielen Fällen ist Quellcode enthalten, der als Beispiel für typische Implementierungen dient, um Entwickler bei der Erstellung ihrer eigenen benutzerdefinierten Anweisungen und Beschleunigungsstrategien für ihre Anwendung anzuleiten. Das Tiny-ML-Plattform-Konfigurationswerkzeug ist im Standard-Efinix-Werkzeugfluss für Entwickler enthalten, die den Standard-Flow und die Beschleunigung ohne weitere Optimierung nutzen möchten.

Autor

Mark Oliver, Vizepräsident für Marketing und Geschäftsentwicklung bei Efinix