Welche KI-Lösung passt zu mir?

18.12.2023 - Konzepte für applikationsspezifische Embedded-Systeme

Das Thema Künstliche Intelligenz (KI) hat ein hohes Interesse in der Öffentlichkeit gefunden, mit zumeist Server- oder Cloud-gestützten Lösungen. Für den Embedded-Bereich gibt es allerdings einige andere Konzepte, die besser zu den sehr vielfältigen Applikationen passen – und meist deutlich weniger Ressourcen verbrauchen. Ein Überblick.

Programme wie ChatGPT haben viel Aufmerksamkeit für das Thema KI generiert und zahlreiche Diskussion angestoßen. Dabei wird allerdings oftmals der enorme Aufwand dahinter übersehen, der in das Training der Modelle floss, welche Server-Farmen dazu notwendig waren und welchen Energieeinsatz der laufende Betrieb verlangt. Genaue Zahle liegen leider nicht vor, aber Schätzungen gehen davon aus, dass mehr als 1.000 MWh für das Training von ChatGPT benötigt wurden und für den täglichen Betrieb über 260 MWh. Für Embedded-Anwendungen unvorstellbare Zahlen – es müssen also andere, deutlich Ressourcen-schonendere Ansätze verfolgt werden.

Dies haben viele Halbleiterhersteller erkannt und bieten diverse Lösungen für KI-Anwendungen an, die nur eine geringe Leistungsaufnahme im einstelligen Watt-Bereich haben. Am häufigsten sind die Kombinationen aus:

- CPU mit integrierter General Purpose Computation on Graphics Processing Unit (GPGPU)

- CPU mit integrierter NPU

- CPU mit externem KI-Beschleuniger

Etwas seltener im Embedded-Bereich sind die Kombinationen:

- CPU mit FPGA

- CPU mit DSP

- Cloudbasiert

Embedded-System streng an Leistungsbedarf ausrichten

Auch wenn die meisten Halbleiterhersteller von ihrem jeweiligen Ansatz überzeugt sind, so ist es im Embedded-Bereich zentral, stets die applikationsspezifischen Rahmenbedingungen im Auge zu behalten. Braucht die Embedded-Anwendung keine aufwendige Grafik, dann sind Prozessoren mit leistungsfähigen Grafikbeschleunigern (GPGPU) selten eingeplant – häufig ist der Energiebedarf/Kühlaufwand zu hoch.

Hier punkten CPUs mit integrierter NPU (Neural Processing Unit) sowie externe KI-Beschleuniger. Letztere lassen sich über einen größeren Performance-Bereich hinweg skalieren, benötigen allerdings etwas mehr Platz auf der Leiterplatte und haben einen größeren Integrationsaufwand bei der Software. Im Prozessor integrierte NPUs sind hier anspruchsloser, allerdings gibt es bei den entsprechenden CPUs bislang nur die Wahl zwischen „Mit“ und „Ohne“, was die KI-Skalierungsmöglichkeit doch etwas einschränkt.

Die Kombination von CPU mit FPGA benötigt nicht nur mehr Platz, die Programmierung des FPGA verlangt ein sehr spezifisches Know-how, über das nur die wenigsten Software-Programmierer verfügen. Die erzielbare Performance kann den deutlich gestiegenen Entwicklungsaufwand jedoch durchaus rechtfertigen. Allerdings ist die Prototypenentwicklung schwieriger als beim Einsatz von Bausteinen von der Stange, die meistens mit vorgefertigten Software-Beispielen zur Auslieferung kommen.

Auch die Programmierung von integrierten DSPs benötigt zusätzliches Know-how, das allerdings nicht so selten bei den Entwicklern ist, beziehungsweise von Entwicklungswerkzeugen wie Matlab seit Jahren abgedeckt werden. Die Leistungsfähigkeit der integrierten DSPs empfehlen sich meist für Audioverarbeitung im Bereich Predictive Maintenance und Sprachsteuerung.

Cloud basierte KI-Lösungen lassen sich mit erstaunlich schwachen Prozessoren realisieren, setzen aber eine entsprechend leistungsfähige Datenverbindung voraus – Stand-alone-Lösungen sind also außen vor.

Vorhandenes System entscheidet über Erweiterungsmöglichkeiten

Welcher von den jeweiligen Hardware-Ansätzen der richtige für die Applikation ist, hängt auch von den jeweiligen Startvoraussetzungen ab. Soll beispielsweise eine bestehende Applikation mit KI-Funktionen erweitert werden, gibt es durch den bislang eingesetzten Prozessor eine eindeutige Präferenz: So bieten sich CPU-Varianten mit KI-Beschleunigung klar für ein Upgrade an – egal ob per NPU oder GPGPU.

Hat allerdings die Prozessor-Roadmap keine Alternative mit KI-Beschleunigung, dann steigt der Hard- und Software-Aufwand deutlich an. Entweder muss die bestehende Hardware mit einem eigenen Beschleuniger aufgerüstet, per Steckkarte/-modul oder per Re-Design des Boards, oder eine Cloud-Lösung in Betracht gezogenen werden. Ein vollständiger Architekturwechsel, mit einem möglichen Wechsel der Entwicklungswerkzeugkette, ist für ein Upgrade-Projekt ein enormer Aufwand, der schon bei Neuprojekten nicht so einfach darstellbar ist.

Kann ein Anwender das Projekt frei von Altlasten starten, hat er die volle Qual der Wahl. Hier kommt es dann auf die jeweilige KI-Erfahrung der Entwickler an, um den Performance-Bedarf abschätzen zu können. Im Zweifelsfall ist ein Modulansatz der beste Weg, um sich an die richtige Leistungsklasse heranzutasten.

Verfügbarkeit: neueste Technik oder verlässliche Update-Zyklen

Ein weiterer, nicht zu unterschätzender Gesichtspunkt ist die langfristige Verfügbarkeit. Zum einen ist viel Dynamik im Markt, was die technische Umsetzung der KI-Beschleuniger angeht, also ein rascher Produktwechsel durch einige Anbieter erfolgt. Zum anderen sind in diesem Umfeld viele Start-ups aktiv, deren langfristigen Geschäftsfähigkeit noch unbewiesen ist.

Auf der Software-Seite bietet sich der Einsatz einer KI-spezifischen Abstraktionsebene wie oneAPI oder SYCL an, die für den Einsatz in verschiedenen Rechenbeschleunigerarchitekturen, einschließlich GPGPUs, KI-Beschleunigern und FPGAs, vorgesehen ist. Dies ermöglicht die Software-Entwicklung vorzuziehen und die Hardware-Entscheidung nach hinten zu verschieben. Allerdings muss man mit möglichen Einschränkungen bei den Programmiersprachen und einem höheren Ressourcenbedarf rechnen.

KI oft noch Neuland, ein Architekturwechsel eine zusätzliche Belastung

Für viele Entwickler ist das Thema KI eindeutig Neuland und sie sind noch am Anfang der Lernkurve. Der Know-how-Erwerb sollte deshalb möglichst ungestört erfolgen, also ein extremer Architekturwechsel und/oder der komplette Wechsel der Entwicklungs-Tool-Kette vermieden werden. Mit Modultechnik von einem Anbieter mit breiter Produktpalette hält man sich möglichst viele Optionen offen – sowohl bei der Konzeption eines Projekts als auch bei der Anpassung an die neu gewonnenen Erkenntnisse.

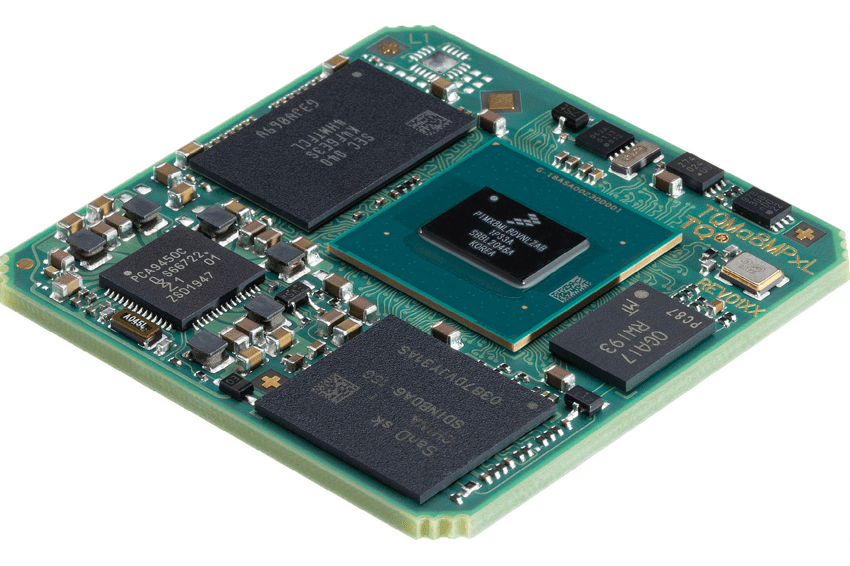

Ein Beispiel für die Wahlfreiheit durch einen unabhängigen Hardware-Anbieter liefert TQ für Embedded-Lösungen im Bereich Künstliche Intelligenz & Machine Learning anhand der Computer-on-Modules TQMxE40M und TQMa8MPxL: Das COM-Express-Mini-Modul TQMxE40M nutzt die Intel-Atom-Prozessoren mit integrierter KI-Unterstützung. Auf der Software-Seite kommen hinzu das Intel Openvino-Toolkit unter Windows 10 und Linux für die schnelle Entwicklung von Hochleistungs-Computer-Vision, das Intel Deep Learning Development Toolkit und ein optimierter Open-CV-Support (Open Computer Vision). Außerdem unterstützen vortrainierte Modelle und Code-Beispiele die Entwicklung. Dadurch stehen Anwendungsfelder wie Gesichtserkennung, Gestenerkennung, mobile Roboter und optisches Tracking zur Verfügung.

Embedded-KI-System mit ARM-CPUs

Auch bei den ARM-basierten CPUs gewinnt das Thema künstliche Intelligenz und Machine Learning an Bedeutung. Das Embedded-Modul TQMa8MPxL mit dem i.MX 8M Plus von NXP unterstützt mit vielen Features, einer integrierten NPU mit bis zu 2,3 TOPS und einer IPU (Image Processor Unit) mit 2 x 187 MPix bei der Umsetzung von Applikationen, bei denen künstliche Intelligenz, Machine Learning/Vision zum Einsatz kommen soll. Für grafisch anspruchsvolle Anwendungen stehen eine GPU und mehrere Grafikschnittstellen bereit.

Diese Vielseitigkeit lässt schon kaum Wünsche offen, um zukunftsorientierte Projekte zu realisieren. Als Anbieter von Embedded-Modulen mit Prozessoren von Intel, NXP, Renesas und Texas Instruments hat TQ Zugriff auf die Roadmaps der Halbleiterhersteller und kann so die eigene Produktpalette an KI-fähigen Baugruppen praxisgerecht erweitern.

Autor

Manne Kreuzer, Technik Support/Produktmarketing TQ-Embedded

Kontakt

TQ-Systems GmbH

Mühlstr. 2, Gut Delling

82229 Seefeld

Deutschland

+49 8153 9308 0

+49 8153 9308 7245