Ereignisbasierte Bilderfassung: Effiziente Bildverarbeitung für Industrie 4.0 und Smart Cities

25.04.2024 - Event-basierte Vision-Sensoren

Die ereignisbasierte Bildgebung kann in manchen Anwendungen die traditionelle Bildverarbeitung ablösen. Denn diese Methode ermöglicht eine effiziente und datenarme Erfassung von Bildern, insbesondere für Anwendungen in Industrie 4.0, Robotik und Smart Cities.

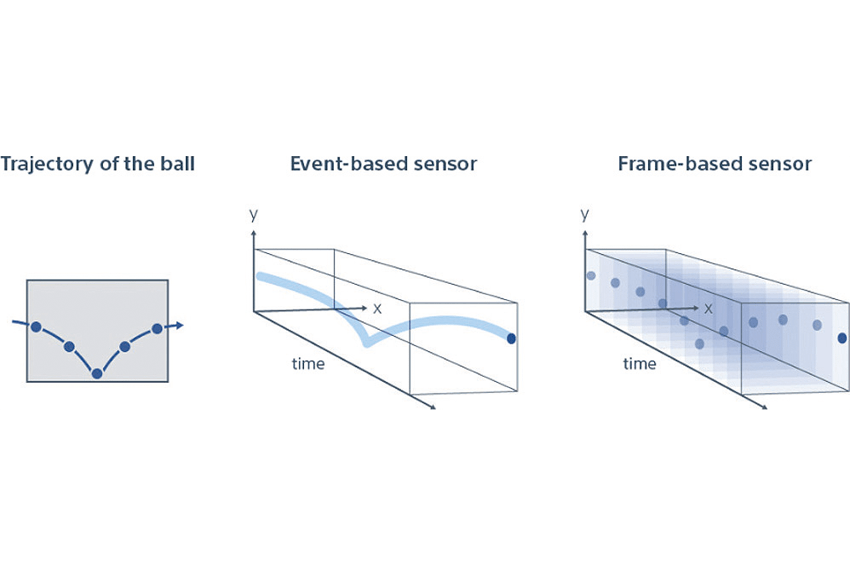

Aktuell basiert die maschinelle Bildverarbeitung immer noch überwiegend darauf, die Daten aller Pixel des Sensors Bild-für-Bild zu erfassen, wobei konventionelle RGB-Bildgebungssysteme dabei für jedes Bild das gesamte Sensor-Sichtfeld erfassen müssen (sowohl bei dynamischen als auch statischen Sequenzen). Obwohl das bei vielen Anwendungsfällen effektiv ist, gibt es Umstände, in denen das sehr problematisch werden kann. Die Rate, mit der Bilddaten erfasst werden müssen, und die Bandbreitenrestriktionen, denen manche Anwendungen unterliegen, sind nur schwer mit einer Frame-orientierten Bilderfassung zu vereinbaren. Dazu gehören Anwendungen industrieller IoT (IIoT), Robotik oder Smart City, die die Bildverarbeitungssysteme vor große Herausforderungen stellen, etwa hinsichtlich der Reaktionszeit. Aufgrund dieser Faktoren gibt es jetzt einen klaren Bedarf, die auftretende Datenübertragungsmenge zu reduzieren. Daraus folgt, dass die Bildgebungstechnologie neu gedacht werden muss. Um das zu erreichen, hat sich die Optoelektronik von der Natur inspirieren lassen.

Die visuelle Wahrnehmung von Maschinen ändern

Die ereignisbasierte Bildgebung ermöglicht es, die Datenerfassung wesentlich effizienter zu gestalten. Dadurch lassen sich Anwendungen mit geringer Bandbreite oder kurzen Latenzzeiten besser bedienen. Denn während sich die traditionelle maschinelle Bildverarbeitung aus der Fotografie entwickelt hat und daher das Erfassen eines ganzen Bildes im Zentrum steht, gelten für die ereignisgesteuerte Bilderfassung dieselben Grundprinzipien wie für das Sehen von Menschen und Tieren: Der menschliche Sehnerv verfügt nur über eine begrenzte Bandbreite, über die visuelle Daten übertragen werden können. Anstatt das gesamte Sichtfeld ständig zu aktualisieren, informieren unsere Augen das Gehirn lediglich über alle auftretenden Veränderungen. Die Anwendung des gleichen Konzepts auf die maschinelle Bildverarbeitung führt zu einer stark reduzierten Datenmenge und einer schnelleren Aktualisierungsrate.

Vorteile des ereignisbasierten Sehens

Es gibt eine Vielzahl von Situationen, in denen die ereignisbasierte Bildgebung von Vorteil ist. Dazu gehören fahrerlose Transportsysteme (FTS), die sich durch Fabriken und Lagerhallen bewegen oder eine hochpräzise Tiefenmessung durch die Projektion strukturierter Lichtmuster auf ein zu untersuchendes Objekt, wobei auftretende Musterverzerrungen mit einer Genauigkeit von weniger als einem Millimeter bei Geschwindigkeiten von mehr als 100 Hz bestimmt werden können.

Eine weniger datenintensive Bildgebung verringert auch den für die Kollisionsvermeidung erforderlichen Verarbeitungsaufwand. Eine weitere wichtige Aufgabe ist die 3D-Bewegungsverfolgung. Diese ermöglicht es beispielsweise Robotern, Gegenstände von einem Förderband aufzunehmen. Weitere erwähnenswerte Aufgaben sind die automatisierte Palettierung, Paketsortierung, Schwingungsanalyse im GHz Bereich, oder die Hochgeschwindigkeitszählung von Stückgut.

Da die ereignisbasierte Bildgebung weniger Daten generiert, kann der damit verbundene Aspekt der künstlichen Intelligenz (KI) mit geringeren Investitionen in Rechenressourcen und weniger komplexen Stacks optimiert werden. Es besteht auch die Möglichkeit, den Trainingsaufwand für zugehörige KI-Algorithmen zu senken, da die Daten bereits in einer vereinfachten Form vorliegen. Die ereignisbasierte Bildgebung ist auch unter dem Gesichtspunkt des Schutzes der Privatsphäre von Bedeutung. Verglichen mit RGB-Kamerasystemen können beispielsweise Smart-City-Anwendungen die Anonymität des Einzelnen viel besser wahren.

Event-Kameras: das technische Prinzip

Die ereignisgesteuerte Bilderfassung kann die Daten für Hochgeschwindigkeitsuntersuchungen von Phänomenen liefern, für die eine so geringe Latenz nötig ist, wie sie herkömmliche Frame-basierte Systeme nicht erreichen. Sony setzt dazu seine „event-based vision sensors“ (EVS) oder zu Deutsch ereignisbasierte Vision-Sensoren ein. Dabei liegt der Schwerpunkt auf der Wahrnehmung von Leuchtdichteänderungen innerhalb einer Szene, sodass die Verfolgung von Bewegungen und die Bestimmung von Vibrationen ohne großen Rechenaufwand möglich sind.

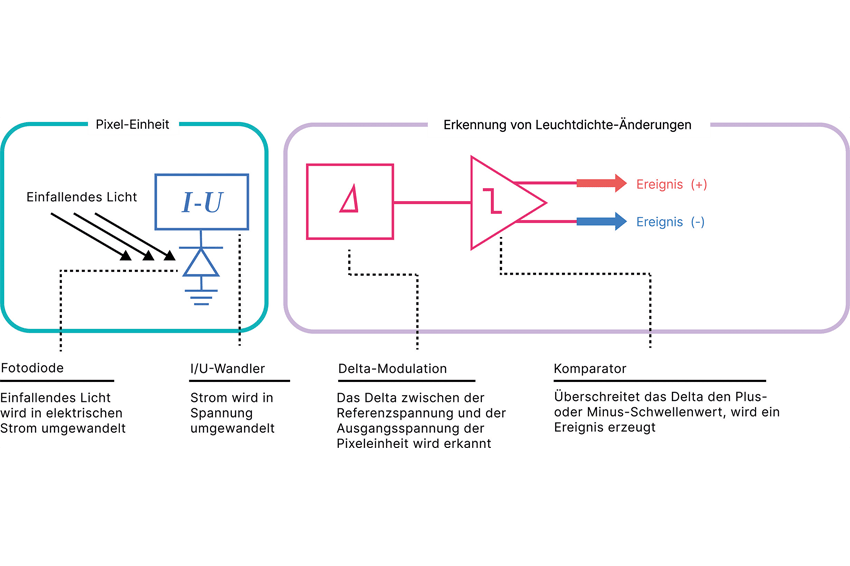

Jeder Pixel besteht aus einer Lichtempfangseinheit und einer Leuchtdichte-Erfassungseinheit. Photonen, die auf die Lichtempfangseinheit treffen, werden in eine Spannung umgewandelt. Dann bestimmt eine Differenzerkennungsschaltung, ob es Änderungen (positiv oder negativ) zwischen der, durch das einfallende Licht erzeugten Spannung und der Referenzspannung gibt. Liegt die festgestellte Änderung beidseitig außerhalb eines bestimmten vordefinierten Schwellenwerts, wird vom Komparator ein Ereignis ausgelöst. Anschließend werden die Daten ausgegeben. Jeder Wert, der innerhalb des Schwellenwerts bleibt, wird als nicht relevant eingestuft (zum Beispiel Hintergrundrauschen) und ignoriert.

Die Einstellungen für den positiven/negativen Schwellenwert lassen sich an die spezifischen Anwendungsanforderungen und die Umgebung anpassen. Für jedes Pixel, bei dem eine nennenswerte Lumineszenzänderung aufgetreten ist, gibt das EVS dann die genauen Koordinaten und die Polarität der Änderung aus (von heller zu dunkler oder umgekehrt). Um sicherzustellen, dass Ereignisse entsprechend dem Zeitpunkt ihres Auftretens registriert werden, werden die Daten mit einem Zeitstempel versehen, bevor sie von den EVS-Pixeln ausgegeben werden. Zeitgestempelte Daten werden an die Arbiterschaltung weitergeleitet, die die Ausgabereihenfolge basierend auf dem frühesten empfangenen Ereignis steuert.

Automatisches Anpassen an dynamische Szenen

Damit das EVS weitere Daten erfassen kann, wird der Schaltkreis, welcher mit jedem einzelnen der Sensorpixel verbunden ist, nach jeder Erfassung eines Ereignisses sofort resettet (zurückgesetzt), wobei die Leuchtdichte des letzten Ereignisses als neuer Referenzwert übernommen wird. Die positiven/negativen Schwellenwerte werden dann entsprechend aktualisiert.

Es besteht die Möglichkeit, den EVS zu justieren, wenn der Sensor nicht genügend oder zu viele Daten erfasst. Schwellenwerte können auch dynamisch konfiguriert werden, wenn zu erwarten ist, dass sich die Umgebungsbedingungen im Laufe eines 24-Stunden-Zeitraums ändern. Bei Smart-City-Überwachungsanwendungen können beispielsweise tageszeitliche Änderungen der Hintergrundbeleuchtung dazu führen, dass die angewendeten Schwellenwerte angepasst werden müssen.

EVS können an Orten eingesetzt werden, an denen andere Bildgebungssysteme aufgrund von Einschränkungen des Dynamikbereichs nicht anwendbar wären. Die Leuchtdichte des einfallenden Lichts wird logarithmisch in eine Spannung umgewandelt. Folglich können kleine Unterschiede bei schlechten Lichtverhältnissen erkannt werden. Umgekehrt können auch große Leuchtdichteunterschiede in Szenarien ohne Übersteuerungsprobleme des Sensors gemessen werden.

Pixel- und Logikebene für mehr Lichtempfindlichkeit gestapelt

Im Gegensatz zu konkurrierenden Ereignisbasierten Vision-Sensoren, haben Sonys EVS einige differenzierende Schlüsseleigenschaften. Die größte Alleinstellungsmerkmal ist die sogenannte Stacked-Anordnung von Pixel- und Logikebene: Normalerweise befinden sich beide Elemente bei ereignisbasierten Bildsensorpixeln auf derselben Substrat-Ebene. Dies führt allerdings zu einigen Problemen, da lichtempfindliche Fläche verloren geht.

Bei der EVS-Architektur von Sony sind diese Elemente in verschiedene Schichten integriert. Sie sind also untereinander und nicht nebeneinander angeordnet. Jedes Lichtempfangselement des Pixels (auf der oberen Schicht) wird ergänzt durch ein Logikelement (auf der unteren Schicht) mit integrierten Signalverarbeitungsfunktionen. Das Ergebnis ist weniger ungenutzte Fläche auf dem Pixel. Neben einer höheren Auflösung wird auch eine überlegene Leistung bei schlechten Lichtverhältnissen erreicht, da von jedem Pixel mehr Photonen erfasst werden können. So kann die Latenz verbessert werden, da die Zeit zum Auslesen der jeweiligen Pixel verkürzt wird und somit die Daten schneller vom Bildsensor weitergeleitet werden können. Da fast alle Bildsensoren von Sony (nicht nur die EVS-Sensoren) auf der Stacked-Bauweise basieren, ermöglichen Skaleneffekte die Realisierung aller Vorteile, ohne dass die damit verbundenen Kosten steigen.

Zwei Event-based-Sensoren mit 0,9 und 0,3 Megapixel

Bislang hat Sony zwei EVS auf den Markt gebracht, den IMX636 mit 0,92 Megapixeln im 1/2,5-Format und den IMX637 mit 0,33 Megapixeln im 1/4,5-Format. Beide haben Pixel mit einer Größe von 4,86 x 4,86 μm und sind damit die kleinsten ereignisbasierten Vision-Sensoren, die derzeit auf dem Markt verfügbar sind. Beide Sensoren haben eine zeitliche Auflösung von unter 100 µs und unterstützen eine maximale Ereignisrate von 2,3 Gigaevents/s. Darüber hinaus verfügen die Chips über einen Dynamikbereich von 86 dB, was ihnen eine große Anwendungsbreite verleiht.

Einsatz von ereignisbasierter Bildgebung

Es gibt eine Vielzahl von Industriezweigen, in denen diese Technologie bereits ihre Leistungsfähigkeit unter Beweis stellt. Dazu gehören die Vibrationsüberwachung von Industrieanlagen (zur Unterstützung von vorausschauender Wartung), das Erkennen von Anomalien im Maschinenbetrieb, die Steuerung von Roboterbewegungen, die Inspektion von Produktionslinien, die Entwicklung von Benutzerschnittstellen, die parametrische Überwachung on the edge sowie verschiedene Formen der Maschinenbeschickung.

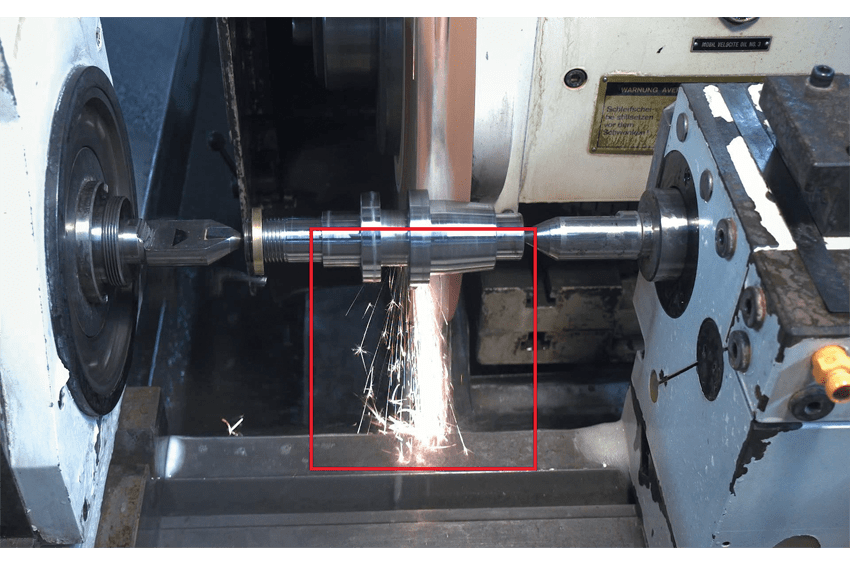

Zu den jüngsten High-Speed-Anwendungen gehört die Überwachung von Funken, die beim Metallschleifen entstehen. EVS ermöglicht die High-Speed-Analyse der Funkenstreuung, die RGB-Sensoren nur schwer erfassen können, da Funken aufgrund von Überbelichtung nicht sichtbar sind. Eine weitere Anwendung ist die Tropfenüberwachung für Flüssigkeiten, um Defekte durch eine bessere Kontrolle der Injektions- und Applikationsbedingungen zu verhindern. EVS misst die Ausströmung, um Geschwindigkeits- und Formänderungen in Flüssigkeiten zu erfassen. RGB-Sensordaten können zwar ebenfalls die Substanz als Flüssigkeit erfassen, vermitteln jedoch keine detaillierten Ausflussinformationen.

Die Technologie kommt auch bei 3D-Messanwendungen zum Einsatz, um die Signalauslesegeschwindigkeit bei Lasertriangulation zu verbessern und eine High-Speed-3D-Messung umzusetzen. Ein deutlicher Vorteil von Event-based-Sensoren gegenüber anderen Techniken besteht darin, dass die High-Speed-Erkennung der Laserlinie nur dann erfolgt, wenn Änderungen auftreten, was die Scanrate erhöht.

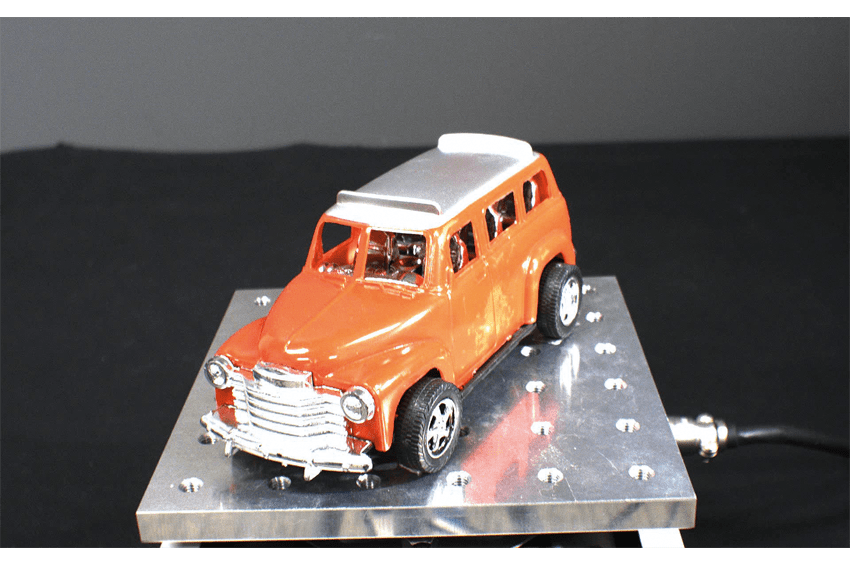

Kürzlich wurde ein auf strukturierter Projektionstechnologie basierendes Proof of Concept im industriellen Kontext durchgeführt, um die Fähigkeiten des Systems in Bezug auf Genauigkeit, Präzision, Geschwindigkeit und Robustheit in unterschiedlichen Umgebungen zu testen. Die Ergebnisse zeigten eine hohe zeitliche Auflösung, einen geringen Stromverbrauch und Unempfindlichkeit gegenüber Bewegungsunschärfe, mit einer Genauigkeit im Submillimeterbereich und präzisen Tiefenmessungen – und damit ein erhebliches Anwendungspotenzial in Branchen wie der Robotik.

Autoren

Tomohiro Takahashi, Senior Business Development Manager für ereignisbasierte Vision Systeme bei Sony Semiconductor Solutions

Tom Jellicoe, Produktmanager für ereignisbasierte Vision und Time-of-Flight Sensoren bei Sony Semiconductor Solutions

Kontakt

Sony Europe B.V., Zweigniederlassung Deutschland

Kemperplatz 1

10785 Berlin

Deutschland

+49 30 41955 1000

+49 30 41955 2000