Beste Ausgangslage für visuelle Intelligenz

State-of-the-Art bei Embedded Vision

Embedded-Vision-Produkte sind klein, modular, plattformunabhängig, leistungsstark und weisen trotz einer guten Performance einen geringen Stromverbrauch auf. Genau das sind die Eigenschaften, die für die meisten Bildverarbeitungsanwendungen erwünscht sind. Doch stellt sich die Frage, warum es diese Produkte mit dieser Auswahl nicht schon früher gab. Die Antwort ist einfach: Es gibt diese Art von Produkten schon lange, nur eben nicht mit dieser Leistungsfähigkeit. Denn das Ziel von Embedded-Vision-Systemen ist meist, die komplette Bildverarbeitung inklusive Hardware und Software in das Gehäuse des Kunden zu integrieren. Das heißt die Kamera ist relativ nahe an der Computerplattform angesiedelt und die anwendungsspezifische Hardware ist im System eingebettet oder mit ihm verbunden. Zusätzliche Komponenten wie Beleuchtung, Sensoren oder digitale I/Os sind integriert oder bereitgestellt.

Vision-in-a-Box-Ansatz für viele Anwendungen geeignet

Ein passendes Beispiel von Matrix Vision ist eine Anwendung für ein britisches Verkehrsüberwachungsunternehmen zur Kennzeichenerkennung. Die Anwendung besitzt zwei abgesetzte Sensorköpfe mit unterschiedlichen Bildsensoren, jeweils für den Tag- bzw. Nachteinsatz. Auf einer separaten Platine ist die LED-Beleuchtung untergebracht. Alles zusammen ist mit einer PowerPC-basierten und mit einer FPGA-bestückten Platine verbunden. Über die integrierten, digitalen I/Os wird ein Bild ausgelöst, das FPGA extrahiert das Kennzeichen aus dem kompletten Bild und sendet die AOI per Netzwerk an einen Cloudserver, der mittels OCR die Zeichen bestimmt. Wer jetzt einwenden möchte, dass PowerPC doch Schnee von gestern ist, dem kann man zustimmen.

Das erwähnte Beispiel ist schon über 13 Jahre alt und basiert auf einer intelligenten Kamera, die kundespezifisch angepasst wurde. Und wie das Beispiel zeigt, sind Smart-Kameras oder intelligente Kameras im weiteren Sinne Vision-in-a-Box-Systeme und damit der Beleg dafür, dass es Embedded Vision schon lange gibt. Zwar schränkte die Leistungsfähigkeit der intelligenten Kameras die Einsatzmöglichkeiten ein, doch wo die intelligenten Kameras eingesetzt werden konnten, verrichten sie noch heute zuverlässig ihre Arbeit.

Die Kennzeichenerkennung ist auch ein Beispiel für Edge Computing. Edge Computing ist bekanntlich der Ansatz, die Datenverarbeitung zu dezentralisieren, sprich: die erste Vorverarbeitung der verdichteten Daten sozusagen an der Kante (edge) zum Netzwerk und die weitere Verdichtung dann im (Cloud-)Server durchzuführen. Im Internet of Things (IoT) stellt Embedded Vision die Bildverarbeitungslösung für Edge Computing dar. Damit ist klar, dass sich auch mit der Industrie 4.0 das Anforderungsprofil von Embedded Vision nicht viel geändert hat.

Erhöhter Leistungsbedarf durch höhere Auflösungen und Bildwiederholraten

Was sich hingegen geändert hat, ist der Leistungsbedarf der potenziellen Anwendungen aufgrund von höheren Auflösungen und Bildwiederholraten, der auch von den neuen Bildsensorgenerationen getrieben wird. Hier profitiert die industrielle Bildverarbeitung als „Trittbrettfahrer“ von Technologie – und Embedded Vision im Speziellen – von den rasanten Entwicklungen im Smartphone-Markt. Diesem Markt ist es zu verdanken, dass die Bedeutung von ARM-Prozessorarchitekturen stetig zunimmt und entsprechende System-on-a-Chip (SoC) etwa von NVIDIA, Broadcom (als Basis des Raspberry Pi) oder NXP sowie System-on-a-Module (SoM) wie SMARC oder COM Express als leistungsstarke Recheneinheiten mit geringem Stromverbrauch mittlerweile die Hauptrolle spielen. Über Carrier Boards werden die System-on-Einheiten lauffähig und können als Mainboard für Vision-in-a-Box dienen. Durch Kooperation mit dem Kunden können Carrier Boards zudem durch Individualisierung weiter in die Kundenapplikation eingebracht werden – auch ein Aspekt, wie Embedded interpretiert werden kann.

Wie kommen die Daten vom Bildsensor zur Recheneinheit?

Ein 12,4 MP-Pregius-Bildsensor der vierten Generation von Sony bei 10 bit (ADC) und 175 Bildern pro Sekunde bei 8 bit führt zu einem Datenvolumen von 2.170 MB/s. Viele Schnittstellen streichen da ihre Segel. Matrix Vision hat sich deswegen für PCI Express (PCIe) entschieden. PCIe ist plattformübergreifend sehr gut standardisiert und vor allem skalierbar. Je nach Lanes und Ausführung sind Nettobandbreiten von 3.200 MB/s möglich, wobei die Bilddaten nahezu latenzfrei direkt in den Speicher geschrieben werden. Damit kann PCIe nahezu jede Anwendungsanforderung erfüllen.

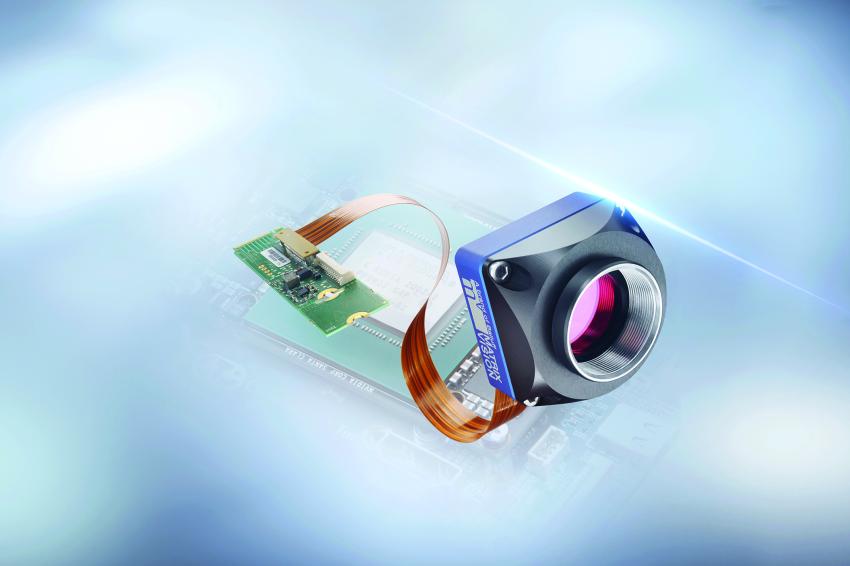

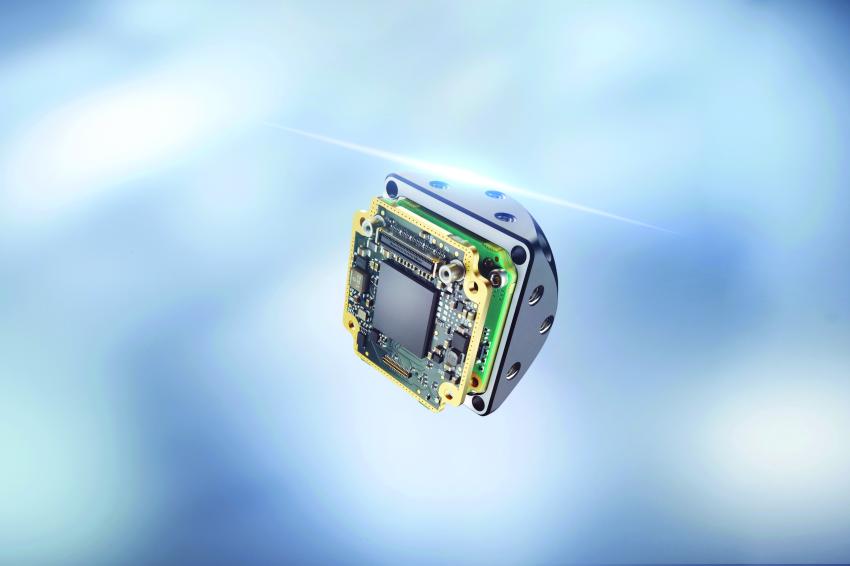

Mit dem Start der PCIe basierten Embedded-Vision-Produktserie hat Matrix Vision einen Baukasten zusammengestellt, in dessen Mittelpunkt die Highend-Embedded-Kameraserie mvBlueNaos steht. Die Kamera kann aus unterschiedlichen Komponenten wie Objektiv, Filter, Objektivhalter, Sensor, Gehäuse, etc. entsprechend der Anwendung flexibel zusammengestellt werden. Zur Anbindung an ein Carrier Board stehen über das All-in-One-Interface Naos for Embedded (N4e) unterschiedliche Adapter für PCIe und M2.M zur Verfügung. Die Kameras haben einen geringen Stromverbrauch und unterstützen ARM-SoCs und Intel-SoMs wie SMARC und COM Express, wobei sie nur eine geringe CPU/GPU-Last verursachen. Sie ermöglichen Multikamerasysteme und unterstützen die KI-Einheiten der SoCs. In der Bilderfassungs-Programmierschnittstelle „mvIMPACT Acquire SDK“ ist PCIe als GenICam-GenTL-Producer und -Consumer realisiert. Somit ist es Kunden möglich, existierende Lösungen mit geringem Aufwand zu migrieren.

MIPI als preislich attraktive Lösung

In Verbindung mit Embedded Vision ist auch oft von MIPI die Rede. MIPI ist für sich betrachtet auch eine Art Standard bei ARM-Mobilprozessoren, aber bedingt eher einen Hardware-Treiber für ein bestimmtes SoC und einen bestimmten MIPI-Sensor (und somit für jedes SoC und jeden Bildsensor einen anderen). Die in Verbindung mit MIPI verwendeten Bildsensoren sind eher low-end und von ihrer Framerate eher bei USB3 platziert. Sofern die Leistung ausreichend ist, kann MIPI eine preislich attraktive Lösung sein.

Das letzte Mosaiksteinchen, welches bei Embedded Vision noch fehlt, ist ein zu GigE Vision und USB3 Vision entsprechender Standard. Hierzu hat die European Machine Vision Association (EMVA) mit der Standardisierungsinitiative Ende 2019 die Weichen gestellt. Besser kann die Ausgangslage für Embedded Vision nicht sein.

Autor

Ulli Lansche, Technischer Redakteur